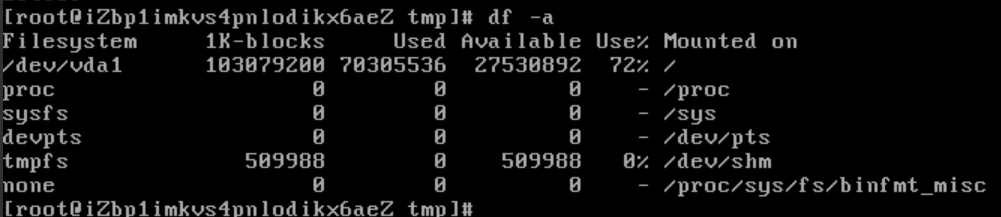

昨天发了一天文章,inode100%故障导致无法上传文件,今天空间又满了,不得不再次仔细核查这个问题,终于找到了罪魁祸首,那就是/var/spool/clientmqueue这个目录下存有海量的日志内容,估算这个目录下有千万级别的小文件,难怪会导致inode用完这个奇葩问题。

ps:不要尝试在wdcp或者宝塔面板中打开这个文件夹,那一定会卡死。

经过查阅资料,发现linux下的cron定时任务在没有重定向的情况下,就会将每次的执行结果发到/var/spool/clientmqueue这个文件夹下,我的论坛使用rsync做远程附件自动同步,为了达到近乎实时同步的效果,5秒钟执行一次同步,这样原因就很明显了,也就是5秒钟就会在clientmqueue在文件夹下生成一个文件,每天会生成17280个文件,一个月就会生成518400个文件……我这个用了一年了,大概生成了6303200个文件,多么恐怖的一个数字,这些文件都很小,不到1kb,但是都需要占用索引,这也就解释了为什么空间还有27G但是inode用满了。

同时很奇怪的是,昨天在统计文件个数的时候,竟然没统计出来这个文件夹,今天重新做了一次仔细看了下,数字是0,估计脚本直接挂了。

用其它统计大小和文件个数的命令,都是内存不够导致直接被kill了……

如何清除linux系统清除/var/spool/clientmqueue下大量日志教程

找到了问题,就要着手解决了,删除这么多的文件夹,还真成为一个大问题,

常用的rm -rf *时候会提示:

“-bash: /bin/rm: Argument list too long“..

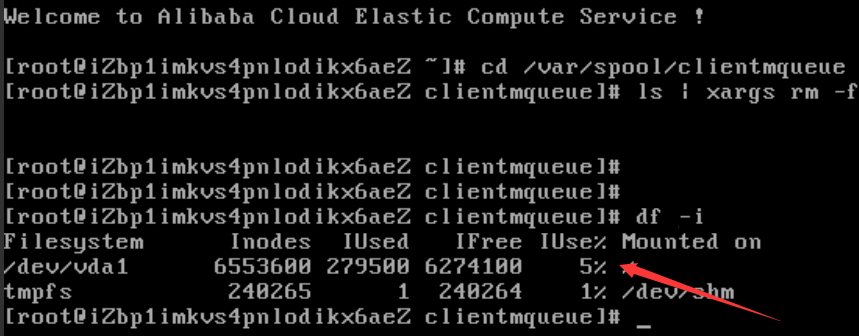

需要使用ls | xargs rm -f命令删除,如下,先cd切换到clientmqueue下,然后执行命令

# cd ar/spool/clientmqueue

# ls | xargs rm -f

执行这个命令的时候,又遇到了问题,那就是我的这个附件服务器用的是1U1G5M的,小内存大带宽,然后执行命令的时候一直提示内存不够……关了网站依然不够用,最后没办法,升级到1U2G后解决。

此命令大概执行了一个小时才全部清空clientmqueue,清空后inode从100%降低到5%,真是世界彻底清净了。

如何避免clientmqueue产生大量文件

直接抛弃命令执行的结果,每条计划任务命令后加> /dev/null 2>&1即可。

具体我的命令是:

* * * * * /root/rs.sh >/dev/null 2>&1

* * * * * sleep 5; /root/rs.sh >/dev/null 2>&1

* * * * * sleep 10; /root/rs.sh >/dev/null 2>&1

* * * * * sleep 15; /root/rs.sh >/dev/null 2>&1

* * * * * sleep 20; /root/rs.sh >/dev/null 2>&1

* * * * * sleep 25; /root/rs.sh >/dev/null 2>&1

* * * * * sleep 30; /root/rs.sh >/dev/null 2>&1

* * * * * sleep 35; /root/rs.sh >/dev/null 2>&1

* * * * * sleep 40; /root/rs.sh >/dev/null 2>&1

* * * * * sleep 45; /root/rs.sh >/dev/null 2>&1

* * * * * sleep 50; /root/rs.sh >/dev/null 2>&1

* * * * * sleep 55; /root/rs.sh >/dev/null 2>&1

具体根据你自己的任务计划修改。

修改前后测试,加了> /dev/null 2>&1后clientmqueue不会产生新的文件,终于彻底解决了这个问题。